浙江在线11月26日讯(记者 梅玲玲 钱洁瑗 通讯员 吴建书 叶健)当人工智能的浪潮席卷全球,算力需求一路狂奔,数据中心的扩张速度也达到了前所未有的水平。

在大型数据中心,密密麻麻的服务器在高速运转时产生大量热量,传统风冷系统的风扇即便飞速旋转,也无法及时将热量排出,就像在炎炎夏日,仅靠一把小风扇难以让整个房间凉爽下来。

在超负荷运转发热时,服务器是否能来个“冷水浴”?

浸泡在浸没式冷却液里的电脑和手机5年后仍能正常工作。 记者 钱洁瑗 摄

依托十余年氟化工技术积累,位于衢州的巨化集团联合北京化工大学、中国科学院化学研究所等高校和机构,给服务器量身定制“泡澡水”——浸没式冷却液。这种特殊液体不仅能高效带走热量,更能显著提升服务器使用寿命,为AI时代数据中心散热难题提供了有效方案。

不让电路板短路的“水”

水是电子设备的“天敌”,给服务器“泡澡”会不会导致短路死机?

在巨化科技展厅,一个小型封闭式“鱼缸”给出了答案。缸内浸泡的不是鱼虾,而是笔记本电脑和手机,“它们已经在功能性样机中泡了5年,性能依然稳定。”巨化技术中心党委委员、浙江创氟高科新材料有限公司副总经理雷志刚一直从事含氟精细化学品的研发工作。他告诉记者,这种看似像水一样的冷却液是经过特殊处理的氟化液,具有极高的绝缘性,即使直接接触电路板也不会造成短路。

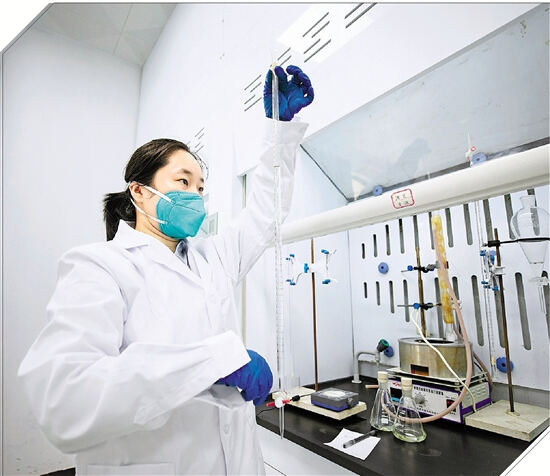

工作人员在对出产产品进行检验分析。记者 钱洁瑗 摄

现场的测试令人称奇,我们拨通了泡在冷却液里的手机号码,屏幕瞬间亮起,并显示完整号码;浸泡5年的笔记本和手机的组件也没有被腐蚀、生锈的情况。

不导电、不短路、不腐蚀,这只是表面优点。浸没式冷却液通过液体循环将热量传导到外界,无需风扇及空调散热,以高效散热、节能降耗的优势,已成为AI时代数据中心的“降温神器”。

雷志刚进一步解释,电源使用效率(PUE)是衡量数据中心能源效率的核心指标,数字越接近1,说明电费花得越值,浪费的热量越少。传统风冷数据中心的PUE值通常在1.5以上,而浸没式液冷可将PUE降至1.07,非IT能耗降低80%以上,远超国家标准。

“AI的瓶颈是算力,算力的瓶颈是电力。”这句科技界的流行语揭示了数据中心已成为能耗大户。据北京理工大学今年发布的《数据中心综合能耗及其灵活性预测报告》,到2030年,我国数据中心用电负荷将达1.05亿千瓦,全国数据中心总用电量约为5257.6亿千瓦时,用电量将占到全社会总用电量的4.8%。

“如果把这个技术全部推广应用的话,全国在计算中心冷却这一块,就可以减少1000亿度用电,这相当于一个三峡水电站全年的发电量。”中国工程院院士、浙江大学衢州研究院院长任其龙表示,浸没式冷却液在“双碳”(碳达峰和碳中和目标)、节能方面所带来的效益巨大。

从3升到千吨的突破

在这场散热革命中,看似平淡的冷却液曾长期被国外垄断,按“公斤”报价,1000公斤的价格动辄达几十万甚至上百万元。

打破垄断实现国产替代,成为国内行业的共同追求。6年前,有客户找到巨化集团合作。对方发现该集团研制的全氟聚醚具备冷却液不导电、不短路、不腐蚀的性能,希望共同攻关冷却液国产化技术。

起步阶段的挑战超乎想象。雷志刚回忆,当时团队一天只能小批量生产3升全氟聚醚,而客户的数据中心3个月就需要800升冷却液。更艰巨的是,团队还要完成对几百种服务器材料的兼容性、物理性等所有指标测试。

于是,技术中心成立推进专班和五个项目小组。“在倒计时的100天时间里,好多同事带着棉被来上班,租借相关设备,连夜奋战,最终摸清了反应条件,获得目标产物。”雷志刚说。当年9月上旬团队完成了产品测试,11月完成制备并逐步包装入库,12月10日,自主研发的冷却液出厂,性能指标与国际竞品相当,填补了国内高性能大数据中心专用冷却液的空白。

中国工程院党组成员、秘书长陈建峰院士在今年中国国际大数据产业博览会上特别提到,巨化集团通过反应合成技术、产物分离纯化技术创新,成功打通浸没冷却材料合成纯化工艺,突破核心技术的工业放大难题,已成功实现千吨级产业化示范线建设。

如今,浸没式冷却液入选国内首批次新材料名单,已进入阿里巴巴、腾讯等头部科技企业的数据中心供应链。为了进一步推动液冷产品的国产化进程,该集团建立了千吨级生产线,所产冷却液价格仅为进口产品的1/4,从而加速液冷产品在市场上的国产替代进程。

打造液冷“一站式”生态

在巨化集团下属的子公司浙江巨冷科技有限公司(以下简称“巨冷科技”)所建的智算数据中心机房,摆放着一台台酷似白色冷柜的单相浸没式液冷设备。打开柜门,一列列服务器严丝合缝地浸没在液体中,室内安静无噪音。

“这是我们自主研发的单相浸没式液冷系统。”巨冷科技董事长鲍处瑾表示,当前智算芯片热流密度持续攀升,传统风冷技术已难以满足智算中心的散热需求。而单相浸没式液冷技术,能将服务器等IT核心部件完全浸没在绝缘冷却液中,通过液体循环将热量导出至外部散热单元,彻底摆脱了对空调与风扇的依赖。

除静音运行,该技术的环境适应性优势也很突出。服务器被冷却液完全隔绝,可有效规避高温、高湿、灰尘等外部环境因素的干扰,能够在全球各类气象条件的地区灵活部署。同时,稳定的工作温度和与空气杂质的隔离,也减缓了元器件的老化速度,大幅延长高价值智算服务器的使用寿命。

“液冷远不是换一种散热方式这么简单。”陈建峰院士说,浸没式液冷是跨专业的跃迁式技术变革,需多领域的高度协同研发。规模化应用需突破冷却液的选型和量产、液冷热控防护系统设计以及与之相配套的液冷专用服务器等难题。

为破解这些瓶颈,巨化集团与巨冷科技联合北京化工大学、中国科学院化学所、中国科学院有机所、东南大学等组成产学研用团队,成功揭榜科技部“十四五”国家重点研发项目——“数据中心液冷热管理材料研发及应用”。团队参编的标准,于2023年8月经工信部批准正式实施,成为首个液冷行业标准,填补了国内数据中心相关领域行业标准空白。

“我们已形成冷却液、热管理设备、浸没式液冷专用服务器为一体的整体解决方案,具备单相浸没式液冷数据(智算/超算)中心从设计、建设、安装调试到交付的交钥匙能力,解决方案已延伸到储能液冷和5G bbu基站液冷等领域。所建项目获选国家发展改革委联合十部委发布的首批《绿色低碳先进技术示范清单》。”鲍处瑾表示,目前,上海阿里云液冷项目、中国电信天翼云液冷智算中心、中国移动庆阳液冷数据中心交付工作已完成,东数西算(庆阳)枢纽节点移动液冷智算中心、酒泉数投液冷数据中心、衢州浸没液冷国产万卡集群建设正同步开展。接下来,团队还将加大研发投入,提前部署未来迭代技术,立足衢州辐射全球,为中国液冷技术注入更强动力。

【链接】AI奔跑为何需要“冷却”护航

全球进入人工智能竞速赛,大模型背后的算力竞赛愈演愈烈。算力,作为数据处理能力的核心,其背后是庞大的算力基础设施——成千上万台服务器在数据中心昼夜不停地运转。然而,算力每提升一步,伴随而来的是惊人的能源消耗,其中散热已成为制约发展的关键瓶颈之一。

那么,为什么算力时代的热耗问题如此突出?

首先,人工智能模型的训练过程是典型的“电老虎”。以拥有1750亿参数的GPT-3为例,其单次训练耗电量高达约128.7万度,相当于美国121户家庭一年的用电总量。而随着模型参数规模不断攀升,训练所需电力更是呈几何级增长。

但这仅仅是开始。训练完成后的“推理阶段”——即用户日常使用AI的过程,耗电量同样惊人。据国际能源署2024年数据,ChatGPT每响应一次请求,平均耗电2.9瓦时,相当于点亮一个60瓦灯泡近三分钟。随着AI应用普及,海量用户持续调用模型,累积耗电量将不断攀升。

有数据显示,在AI数据中心内部,电力消耗主要来自两部分:约40%用于计算本身,另外40%则用于设备冷却,其余为其他信息技术设备用电。芯片在工作时热流密度极高,局部热点可达150W/cm,这样的热流密度意味着在指甲盖大小的面积上,每秒产生的热量足以在几分钟内烧开一杯水。如果不能及时散热,芯片性能会急剧下降,甚至引发故障,严重影响AI服务的稳定性与效率。

由此可见,算力的每一次飞跃,都伴随着散热技术的严峻考验。在算力竞赛的背后,实则也是一场“散热攻坚战”。唯有突破散热瓶颈,才能为AI的持续奔跑提供坚实保障。

(记者 朱平 整理)

版权和免责申明

凡注有"浙江在线"或电头为"浙江在线"的稿件,均为浙江在线独家版权所有,未经许可不得转载或镜像;授权转载必须注明来源为"浙江在线",并保留"浙江在线"的电头。